Samochody autonomiczne a etyka: jakie dylematy stoją przed projektantami i użytkownikami takich pojazdów?

Wyzwania etyczne w projektowaniu samochodów autonomicznych

Projektowanie samochodów autonomicznych wiąże się z licznymi wyzwaniami etycznymi, które wymagają szczególnej uwagi zarówno ze strony inżynierów, jak i przyszłych użytkowników. Jednym z najważniejszych dylematów jest zaprogramowanie algorytmów decydujących o tym, jak pojazd powinien zachować się w sytuacjach zagrożenia życia. Odpowiedzialność za decyzje podjęte przez sztuczną inteligencję staje się kwestią sporną – kto ponosi winę w przypadku wypadku: producent, programista, czy użytkownik?

Kolejną istotną kwestią jest ochrona prywatności. Samochody autonomiczne zbierają ogromne ilości danych, które mogą obejmować informacje o lokalizacji, zachowaniach użytkowników, a nawet o sposobie prowadzenia pojazdu. Zarządzanie tymi danymi w sposób etyczny stanowi ogromne wyzwanie, zwłaszcza w kontekście ryzyka nadużyć lub wycieków informacji.

Projektanci muszą również zmagać się z problemem tzw. „efektu czarnej skrzynki” – trudności w wyjaśnieniu, dlaczego samodzielny pojazd podjął określone decyzje na drodze. Transparentność działania algorytmów i możliwość ich audytu staje się kluczowa dla budowania zaufania społecznego. W kontekście etyki, konieczne jest tworzenie standardów i wytycznych, które pozwolą jasno określić, jak postępować w potencjalnych sytuacjach konfliktowych.

Niezwykle ważne jest także uwzględnienie aspektów sprawiedliwości społecznej – autonomiczne pojazdy nie powinny faworyzować żadnej grupy użytkowników na drodze. Wszystkie te wyzwania pokazują, że etyka odgrywa kluczową rolę w dalszym rozwoju samochodów autonomicznych.

Odpowiedzialność za decyzje pojazdu – twórcy kontra użytkownicy

Autonomiczne samochody stają się coraz bardziej obecne w debacie publicznej, a ich wprowadzenie rodzi wiele pytań etycznych i prawnych. Jednym z kluczowych zagadnień jest rozdzielenie odpowiedzialności za podejmowane przez pojazd decyzje. W przypadku tradycyjnych samochodów za wszelkie działania odpowiada kierowca. Jednak w sytuacji, gdy za sterowanie pojazdem odpowiada zaawansowane oprogramowanie, odpowiedzialność rozmywa się pomiędzy twórcami technologii oraz użytkownikami.

Twórcy systemów autonomicznych muszą przewidzieć różnorodne scenariusze drogowe, programując reakcje pojazdu zgodnie z określonymi normami etycznymi i prawnymi. Odpowiedzialność spoczywa więc na nich już na etapie projektowania, testowania i wdrażania oprogramowania. Użytkownicy takich samochodów często nie mają możliwości ingerencji w przebieg jazdy, szczególnie na wyższym poziomie autonomii, co oznacza, że ich odpowiedzialność za konkretne zdarzenia może być ograniczona lub nawet całkowicie wykluczona.

Problem pojawia się w przypadku wypadków lub sytuacji, które nie zostały przewidziane przez projektantów. Wtedy odpowiedź na pytanie, kto ponosi odpowiedzialność – programista, producent czy użytkownik – staje się trudna do rozstrzygnięcia. Również społeczne oczekiwania oraz aspekty moralne, takie jak wybór „mniejszego zła”, wymagają głębokiej refleksji zarówno ze strony projektantów, jak i konsumentów.

Dylematy moralne w ekstremalnych sytuacjach na drodze

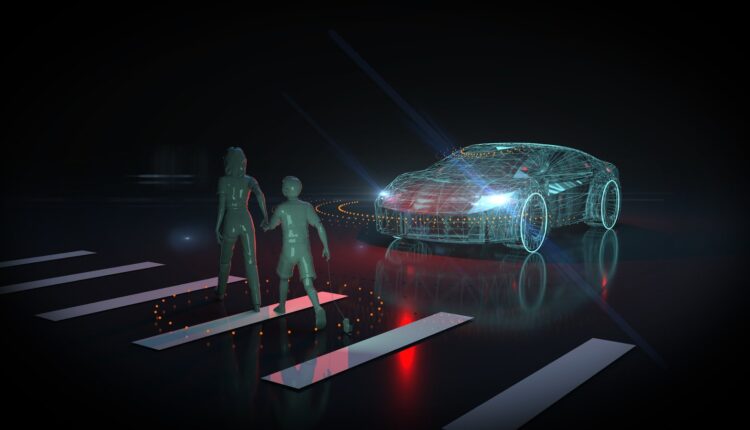

Samochody autonomiczne, wykorzystujące zaawansowane algorytmy sztucznej inteligencji, wprowadzają na drogi nową jakość, ale też wiążą się z poważnymi dylematami moralnymi. Projektanci takich pojazdów muszą już na etapie konstruowania systemów decyzyjnych przewidywać sytuacje ekstremalne, w których nie da się uniknąć wypadku. Przykładem może być słynny dylemat wagonika, czyli konieczność wyboru: czy samochód powinien chronić przede wszystkim pasażerów, czy postronne osoby na drodze?

Decyzje te są trudne, ponieważ dotyczą wartości ludzkiego życia. Jeśli samochód autonomiczny zmuszony jest do wyboru między potrąceniem pieszych a narażeniem życia pasażerów, powstaje pytanie o priorytety. Czy ważniejsze jest bezpieczeństwo osób znajdujących się wewnątrz pojazdu, czy otoczenia? Projektanci muszą więc podejmować decyzje, które mają na celu minimalizację szkód, lecz zawsze mogą spotkać się z krytyką etyczną ze strony użytkowników i społeczeństwa.

Dodatkowo pojawia się zagadnienie odpowiedzialności. Czy za skutki działania pojazdu autonomicznego odpowiedzialny jest jego użytkownik, producent, a może twórcy algorytmów? Pytania te są niezwykle ważne w kontekście rozwoju tej technologii i kształtowania przyszłości transportu.

Wpływ autonomii pojazdów na społeczeństwo i bezpieczeństwo

Samochody autonomiczne to technologia, która może w znaczący sposób wpłynąć na funkcjonowanie społeczeństw, zwłaszcza pod kątem bezpieczeństwa na drogach i etyki. Z jednej strony pojazdy te są zaprojektowane tak, by minimalizować błędy ludzkie, które stanowią jedną z głównych przyczyn wypadków drogowych. Odpowiednio zaprogramowane algorytmy mogą szybciej reagować na zagrożenia i analizować sytuację na drodze w czasie rzeczywistym, zwiększając tym samym poziom bezpieczeństwa uczestników ruchu.

Jednak wraz z rozwojem tej technologii pojawiają się poważne dylematy etyczne. Przykładem może być sytuacja, w której samochód autonomiczny musi wybrać pomiędzy ochroną pasażera a przechodnia. Jak powinien być zaprogramowany taki system? Czy decyzje dotyczące życia i zdrowia ludzi mogą być pozostawione algorytmom? Projektanci muszą rozważać różne scenariusze moralne, by stworzyć pojazd, którego działania będą zgodne z akceptowanymi normami społecznymi.

Również użytkownicy autonomicznych pojazdów muszą zadać sobie pytanie o odpowiedzialność za ewentualne wypadki. Rosnąca rola sztucznej inteligencji w codziennym życiu będzie wymagała wypracowania nowych regulacji prawnych i standardów etycznych, aby technologia ta służyła wszystkim i nie powodowała konfliktów społecznych.